La guerra de la información ha experimentado una transformación radical en la última década. Lo que antes se limitaba a operaciones de propaganda tradicional y desinformación básica ha evolucionado hacia un ecosistema sofisticado donde la inteligencia artificial no solo amplifica los mensajes, sino que personaliza la manipulación emocional a niveles sin precedentes. Esta evolución representa un cambio de paradigma en cómo se desarrollan las operaciones de influencia modernas, combinando precisión algorítmica con ingeniería psicológica.

La convergencia entre psicología persuasiva e inteligencia artificial

El microtargeting no es nuevo en sí mismo. Durante décadas, las campañas políticas y publicitarias han segmentado audiencias según datos demográficos y comportamentales. Sin embargo, la IA ha transformado radicalmente esta práctica. Estudios recientes demuestran que los anuncios políticos personalizados según rasgos de personalidad son significativamente más persuasivos que los no personalizados. Esta personalización ya no requiere equipos humanos analizando datos, sino que puede automatizarse a escala masiva.

La verdadera revolución llega cuando estas capacidades de microtargeting se combinan con tecnologías de síntesis de contenido. Los sistemas de IA generativa actuales pueden crear mensajes persuasivos adaptados a vulnerabilidades psicológicas específicas, sin necesidad de intervención humana. Un estudio publicado en Warning people that they are being microtargeted fails to eliminate persuasio» en Nature confirma que este efecto persuasivo persiste incluso cuando los usuarios son advertidos explícitamente de que están siendo microtargetizados.

Del targeting estratégico a la manipulación emocional

El desarrollo de la IA emocional constituye un factor multiplicador en estas operaciones de influencia. Según investigaciones de On manipulation by emotional AI: UK adults’ views and governance publicado en Frontiers in Sociology, los adultos británicos expresan preocupaciones significativas sobre dos aplicaciones específicas del perfilado emocional con IA:

- Perfilado emocional en redes sociales (involucrando deepfakes, información falsa y teorías conspirativas)

- Perfilado emocional en tecnologías orientadas a niños (donde dispositivos responden a expresiones faciales y verbales)

Estas tecnologías no solo detectan estados emocionales, sino que pueden adaptar contenido en tiempo real para maximizar el impacto emocional. Un sistema de IA avanzado puede ajustar tono, lenguaje y contenido basándose en análisis emocional en tiempo real, personalizando interacciones para maximizar el impacto persuasivo.

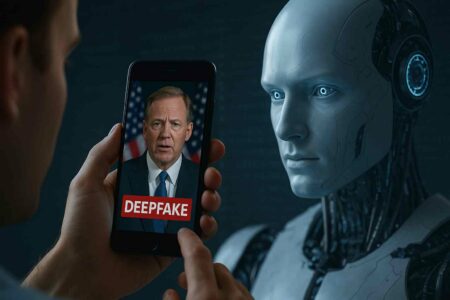

Deepfakes: más allá de la falsificación visual

La tecnología deepfake representa el punto culminante de esta convergencia entre IA generativa y manipulación emocional. Un deepfake no es solo una falsificación visual convincente; es un vector multimodal de persuasión que opera simultáneamente en múltiples niveles cognitivos.

Amaka Peace Onebunne, investigadora de la Universidad del Norte de Illinois, en From Aristotle to AI: Exploring the convergence of deepfakes and persuasion analiza cómo los deepfakes políticos operan en frentes múltiples: «Lingüísticamente, estos videos imitan meticulosamente las voces y la retórica de los políticos, creando una falsa sensación de autenticidad. La representación visual realista crea una conexión innata con la audiencia, fomentando la resonancia emocional y mejorando el poder de los videos para influir en la opinión pública».

Este efecto es particularmente preocupante cuando se combina con operaciones multimodales. Según investigadores de seguridad en The role of deepfakes, artificial intelligence, and open-source intelligence, «Una operación multimodal tiene el potencial de ser a la vez económica y efectiva. Este tipo de operación implica la combinación y coordinación deliberada de varias herramientas híbridas diferentes para causar daño a un individuo, estado, grupo u organización. Por ejemplo, un deepfake que muestra a personal de una misión torturando a una persona local puede combinarse con campañas en redes sociales y medios tradicionales».

Mecanismos de persuasión y vulnerabilidades cognitivas

Los deepfakes emocionales explotan principios psicológicos bien establecidos. La investigación sobre Deepfake Influence Tactics through the Lens of Cialdini’s Principles demuestra cómo estas tecnologías aprovechan vulnerabilidades psicológicas humanas como la confianza y la urgencia para manipular percepciones, emociones y comportamientos.

La persuasión a través de deepfakes opera principalmente mediante tres mecanismos:

- Logos (apelación a la lógica): Utilizando argumentos aparentemente razonables basados en datos falsos o manipulados

- Ethos (apelación a la autoridad): Explotando la credibilidad de figuras públicas reconocibles

- Pathos (apelación a las emociones): Evocando reacciones emocionales fuertes que nublan el juicio crítico

La dimensión emocional resulta especialmente efectiva. Los deepfakes utilizan señales emocionales para obtener respuestas emocionales de los humanos, aprovechando que las emociones son elementos significativos en cada aspecto de la interacción y comunicación humana. Esta manipulación emocional resulta devastadoramente efectiva porque los humanos procesamos información visual más rápidamente que texto, y las emociones impulsan la toma de decisiones, particularmente en política.

El futuro de la manipulación emocional algorítmica

La verdadera preocupación surge al considerar cómo estas tecnologías continuarán evolucionando. Un informe reciente sobre desinformación de AI And Microtargeting Disinformation As A Security Threat predice que la combinación de deepfakes habilitados por IA con microtargeting impulsado por bots elevará las amenazas de desinformación a un nivel totalmente nuevo y peligroso.

El microtargeting impulsado por IA ya ha superado las capacidades tradicionales. Como señala el estudio Power of Persuasion: How AI is Shaping Human Behavior in 2024, «En 2024, la capacidad de IA para la hiperpersonalización permite crear mensajes de marketing casi imposibles de resistir. Por ejemplo, una campaña de marketing impulsada por IA podría no solo sugerir productos basados en compras anteriores, sino también considerar el estado de ánimo actual del consumidor, eventos recientes de la vida e incluso señales sutiles de su comportamiento en línea».

Impacto en la confianza pública y defensas cognitivas

Un estudio técnico reciente de The persuasive effects of political microtargeting in the age of AI documentó una disminución significativa de 9.76 puntos en la confianza pública después de eventos de desinformación que utilizaban deepfakes generados con IA y microtargeting. Esta erosión de confianza tiene graves implicaciones para el funcionamiento de las instituciones democráticas y el discurso público.

Quizás más preocupante aún es la dificultad de desarrollar defensas efectivas. Los investigadores han encontrado que incluso cuando las personas son advertidas explícitamente sobre el microtargeting, los anuncios personalizados mantienen su ventaja persuasiva. Esto sugiere que la mera transparencia puede ser insuficiente como medida defensiva.

Estrategias de protección y resiliencia

Frente a estas amenazas sofisticadas, las estrategias de defensa deben operar en múltiples niveles:

- A nivel técnico: Es urgente desarrollar sistemas de detección de IA adaptativos, métodos de verificación de autenticidad y herramientas para identificar manipulación emocional algorítmica.

- A nivel educativo: Fomentar la alfabetización mediática y la resiliencia cognitiva colectiva resulta esencial. Esto implica no solo enseñar a identificar deepfakes, sino también comprender los mecanismos psicológicos de la persuasión y desarrollar defensas críticas.

- A nivel regulatorio: Se requieren marcos legales internacionales para la Guerra de la Información, enfocados específicamente en el uso de IA para operaciones de influencia y manipulación emocional.

Conclusión: La nueva frontera de la seguridad cognitiva

La convergencia de microtargeting y deepfakes emocionales representa una evolución cualitativa en las operaciones de influencia. Esto no es simplemente una intensificación de tácticas tradicionales, sino una transformación fundamental en cómo la persuasión opera en la era digital.

Si compramos que la información es poder, debemos entender que la desinformación personalizada y emocionalmente manipulativa constituye una forma de poder coercitivo sin precedentes. La capacidad de moldear percepciones, manipular emociones y dirigir comportamientos a escala masiva y personalizada representa un desafío fundamental para la autonomía cognitiva individual y colectiva.

El futuro de la seguridad nacional y democrática dependerá no solo de proteger infraestructuras físicas y digitales, sino también de desarrollar defensas efectivas contra la manipulación cognitiva y emocional algorítmica. La batalla por la verdad se ha transformado en una batalla por las emociones, y las herramientas de esta guerra evolucionan a un ritmo acelerado gracias a la inteligencia artificial.